DDN được thiết kế để vận hành trên nền tảng NVIDIA Rubin, tích hợp Bộ xử lý dữ liệu NVIDIA BlueField-4

Sự phát triển của các mô hình AI sinh (generative AI) quy mô lớn và các tác vụ AI dạng agent đang phơi bày những nút thắt mới trong cách hệ thống tính toán, tổ chức và cung cấp dữ liệu ở quy mô và tốc độ chưa từng có. Các mô hình AI đang vượt qua giới hạn của kiến trúc truyền thống, đặc biệt trong các bài toán như suy luận với ngữ cảnh hàng triệu token, hiệu năng cache phân tán, và suy luận chuyên sâu về dữ liệu – nơi mà trí tuệ dữ liệu, chứ không chỉ sức mạnh tính toán thuần túy, quyết định thành công.

Trong một bài blog gần đây của DDN, chúng tôi đã phân tích lý do vì sao KV cache và các mô hình AI ngữ cảnh dài đang tạo ra những yêu cầu kiến trúc hoàn toàn mới đối với lưu trữ và pipeline dữ liệu. Điều rõ ràng là hạ tầng AI trong tương lai phải liền mạch hơn, mở rộng tốt hơn và thông minh hơn trên toàn bộ các lớp CPU, GPU, DPU, mạng và lưu trữ.

Đây chính là bối cảnh nơi nền tảng NVIDIA Rubin, mạng NVIDIA Spectrum-X Ethernet và bộ xử lý dữ liệu NVIDIA BlueField-4 trở nên đặc biệt quan trọng, đồng thời cũng là nơi nền tảng AI Data Intelligence của DDN giữ vai trò then chốt trong việc tạo ra giá trị kinh doanh thực tế.

Một tầng AI & HPC mới: Nền tảng NVIDIA Rubin

Nền tảng NVIDIA Rubin đại diện cho thế hệ trung tâm dữ liệu AI tham vọng nhất từ trước đến nay. Khác với GPU độc lập truyền thống, NVIDIA Vera Rubin NVL72 là một hệ thống quy mô rack, tích hợp chặt chẽ nhiều bộ xử lý và kết cấu kết nối chuyên biệt để phục vụ các khối lượng công việc AI huấn luyện và suy luận thế hệ mới, kết hợp sức mạnh tính toán, băng thông bộ nhớ và hiệu năng kết nối trong một kiến trúc thống nhất.

Các thành phần chính bao gồm:

- CPU NVIDIA Vera tùy chỉnh: Bộ xử lý Arm 88 nhân, đảm nhiệm điều phối AI/HPC và quản lý dữ liệu hiệu quả.

- GPU NVIDIA Rubin: Thế hệ kế nhiệm của NVIDIA Blackwell, cung cấp hiệu năng lên đến 50 PFLOPS FP4 và 288GB bộ nhớ HBM4 mỗi GPU, tối ưu cho huấn luyện và suy luận.

- NVLink Switch Fabric: Kết nối NVLink thế hệ mới, mang lại băng thông siêu cao giữa các GPU.

- DPU NVIDIA BlueField-4: Bộ xử lý dữ liệu lập trình được, chịu trách nhiệm offload các tác vụ mạng, bảo mật, lưu trữ và hạ tầng, đồng thời cung cấp một tầng KV cache mới để mở rộng bộ nhớ ngữ cảnh và tăng tốc suy luận trong nền tảng NVIDIA Inference Context Memory Storage.

Hệ thống NVIDIA Vera Rubin NVL72 dự kiến bắt đầu được cung cấp vào năm 2026, mang lại hiệu năng AI đa exaFLOP cùng dung lượng bộ nhớ lớn và kết nối tốc độ cao. Những khả năng này được thiết kế để phục vụ làn sóng AI tiếp theo, đặc biệt là các mô hình suy luận ngữ cảnh dài, đa phương thức và thực thi phân tán ở quy mô lớn.

Sự chuyển dịch này đánh dấu bước ngoặt từ việc đơn thuần “thêm GPU” sang xây dựng các AI factory hợp nhất – nơi CPU, GPU, mạng và lưu trữ vận hành như một hệ sinh thái thống nhất.

BlueField-4: DPU vận hành tầng điều hành của AI Factory

Trong bối cảnh kết nối terabit và các tác vụ cache phân tán, CPU máy chủ không còn đủ khả năng xử lý hiệu quả toàn bộ tác vụ mạng, bảo mật và lưu trữ. NVIDIA BlueField-4 DPU ra đời để giải quyết bài toán này.

BlueField-4 là bộ xử lý trung tâm dữ liệu lập trình được, đảm nhiệm độc lập các tác vụ hạ tầng, giúp giải phóng CPU để tập trung vào tính toán AI cốt lõi, đồng thời vận hành một lớp lưu trữ suy luận mới trong NVIDIA Inference Context Memory Storage Platform.

BlueField-4 cung cấp:

- Offload và tăng tốc mạng, kiểm tra gói sâu, dịch vụ bảo mật và xử lý lưu trữ

- Tích hợp CPU Grace 64 nhân để tăng cường năng lực tính toán ngay trên DPU

- Băng thông mạng lên tới 800 Gbps nhờ công nghệ NVIDIA ConnectX-9

- Khả năng hoạt động như bộ điều khiển lưu trữ hiệu năng cao cho AI

Sự kết hợp này biến BlueField-4 thành hệ thần kinh số của AI factory, đảm nhiệm telemetry, bảo mật, điều phối lưu trữ và tăng tốc luồng dữ liệu mà không tạo gánh nặng cho CPU máy chủ.

Vì sao Data Intelligence trở nên then chốt: Từ KV Cache đến pipeline dữ liệu phân tán

Việc chuyển từ suy luận ngữ cảnh ngắn sang suy luận với hàng triệu token đã tạo ra áp lực mới lên cách dữ liệu được cache, phân phối và cập nhật theo thời gian thực.

Những thách thức chính bao gồm:

- Khối lượng dữ liệu làm việc ngày càng lớn, đòi hỏi lớp lưu trữ nhanh và mở rộng hơn

- Cache phân tán phải vượt ra ngoài bộ nhớ của một máy chủ đơn lẻ, yêu cầu điều phối thông minh giữa lưu trữ, mạng và compute

- Sự phối hợp chặt chẽ giữa bộ nhớ GPU, kết nối liên GPU và các lớp cache bền vững để giảm độ trễ và tối đa thông lượng

NVIDIA Rubin kết hợp với BlueField-4 mang đến nền tảng đầu-cuối để mở rộng KV cache cho suy luận ngữ cảnh dài trên toàn rack. Tuy nhiên, để khai thác trọn vẹn tiềm năng này, cần một nền tảng dữ liệu có khả năng lưu trữ, đồng bộ và phân phối dữ liệu ở quy mô exabyte với hiệu năng vượt trội.

Đây chính là vai trò của nền tảng AI Data Intelligence của DDN.

DDN, NVIDIA Rubin & BlueField-4: Tầm nhìn hợp nhất cho hạ tầng dữ liệu AI

DDN đã hợp tác cùng NVIDIA từ năm 2016 và là nhà cung cấp lưu trữ được chứng nhận cho NVIDIA DGX SuperPOD. Trong nhiều năm, DDN đã xây dựng các hệ thống lưu trữ hiệu năng cao nhằm đáp ứng những yêu cầu khắt khe nhất của HPC, doanh nghiệp, cloud và AI.

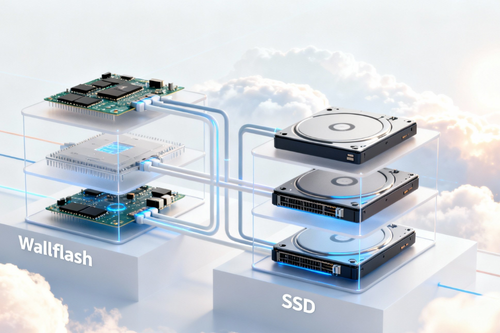

Khi các nền tảng như NVIDIA Rubin với BlueField-4 tiếp tục mở rộng giới hạn compute và luồng dữ liệu, giải pháp của DDN sẽ đóng vai trò trung tâm trong việc:

Truy cập dữ liệu ở quy mô exascale cho huấn luyện và suy luận AI

Nền tảng Rubin mang lại mật độ compute cực cao, nhưng nếu không có lớp lưu trữ đủ mạnh, hiệu năng GPU sẽ bị lãng phí. DDN cung cấp AI data fabric với thông lượng duy trì hàng trăm GB/s, cho phép:

- Nạp dữ liệu huấn luyện khổng lồ một cách liền mạch

- Phân phối động dữ liệu suy luận trên các ngữ cảnh phân tán

- Hỗ trợ các tầng cache phân tán giữa bộ nhớ GPU và lưu trữ bền vững

Hiện tại, DDN đang vận hành hơn 1.000.000 GPU trên các hệ thống AI hàng đầu thế giới, đảm bảo GPU luôn đạt mức sử dụng lên tới 99%.

Điều phối tầng KV cache phân tán

Với các mô hình suy luận đa triệu token, bộ nhớ GPU cục bộ không còn đủ. Nền tảng của DDN hỗ trợ kiến trúc KV cache phân tầng với:

- Truy cập độ trễ cực thấp trên NVMe, Optane và flash

- Đồng bộ và duy trì tập dữ liệu làm việc nhất quán

- Tích hợp BlueField-4 và DOCA để tăng tốc luồng dữ liệu, giảm tải CPU

Kết hợp với NVIDIA Spectrum-X Ethernet, DDN giúp giảm thời gian time-to-first-token (TTFT) từ 20-40% so với lưu trữ truyền thống.

Lưu trữ tích hợp mạng cho AI Factory

Khả năng lập trình của BlueField-4 cho phép DDN triển khai các dịch vụ dữ liệu nhận biết mạng, bao gồm:

- Tăng tốc metadata và control plane

- Ra quyết định đặt dữ liệu theo telemetry thời gian thực

- Bảo mật và quản lý luồng dữ liệu AI đa tenant

Bảo mật, telemetry và quản trị dữ liệu nâng cao

Kết hợp BlueField-4 với nền tảng của DDN cho phép:

- Mã hóa dữ liệu khi lưu trữ và khi truyền

- Phân tách dữ liệu đa tenant an toàn

- Phân tích truy cập dữ liệu theo thời gian thực phục vụ tuân thủ và tối ưu hóa

Định hình con đường cho thế hệ AI tiếp theo

Tương lai của hạ tầng AI không nằm ở từng thành phần riêng lẻ, mà ở sự hợp nhất – hợp nhất phần cứng, mạng và pipeline dữ liệu. NVIDIA Rubin với BlueField-4 thể hiện rõ xu hướng này: không chỉ là thiết bị tính toán, mà là một hệ thống thống nhất từ CPU, GPU đến dữ liệu.

Tuy nhiên, hợp nhất thôi chưa đủ. Thành công của AI trong tương lai sẽ phụ thuộc vào data intelligence – khả năng xây dựng kiến trúc luồng dữ liệu toàn diện, đáp ứng nhu cầu của GPU, DPU và mô hình AI theo thời gian thực.

Tại DDN, chúng tôi đã sẵn sàng cho kỷ nguyên AI factory của Rubin, nơi dữ liệu không còn là điểm nghẽn, mà trở thành động cơ tăng tốc cho chương tiếp theo của AI.

Unitas cam kết đồng hành cùng doanh nghiệp, cung cấp các giải pháp và phân tích an ninh mạng tiên tiến nhất. Để nhận được tư vấn chuyên sâu hoặc hỗ trợ nhanh chóng, vui lòng liên hệ với chúng tôi qua email: info@unitas.vn hoặc Hotline: (+84) 939 586 168.